Relaunches sind oft der Endgegner im SEO. Du kennst das: Es gibt Checklisten, die länger sind als der Code, den wir täglich deployen und trotzdem geht am Ende irgendwas schief. Aber Checklisten abarbeiten ist Web 2.0.

Daniel Kremer hat in seiner Session „Relaunch done right“ gezeigt, warum wir aufhören müssen, stur Excel-Listen abzuhaken und anfangen sollten, wie Ingenieure zu denken. Spoiler: Es geht um Embeddings, Python und die 80/20-Regel.

Die Mutter aller Tools: Screaming Frog

Fangen wir mit dem Offensichtlichen an, weil es einfach gesagt werden muss: Der Screaming Frog war auf der diesjährigen Konferenz der heimliche Star. Für mich ist das Ding alternativlos. Wenn du Daten brauchst, liefert der Frosch. Punkt. Daniel hat klargestellt, dass er ohne saubere Crawl-Daten gar nicht erst anfängt. Wer hier spart oder auf “All-in-One-Suites” vertraut, die nur an der Oberfläche kratzen, hat den Kampf schon vor dem Relaunch verloren.

AI & Engineering: Embeddings statt Bauchgefühl

Jetzt wird es spannend für uns Techies. Daniel hat einen Workflow vorgestellt, der weit über “URL A auf URL B matchen” hinausgeht. Er nutzt Vector Embeddings (z.B. Sentence Transformers*), um Inhalte semantisch zu vergleichen.

Warum ist das genial? Beim Relaunch verändern sich Inhalte oft. Ein simpler Keyword-Abgleich greift zu kurz. Mit Embeddings verwandelst du deinen Content in Vektoren und vergleichst die semantische Nähe zwischen der alten und der neuen Seite.Du kannst nicht einfach den ganzen DOM in den Transformer werfen und auf Magie hoffen. Wie du den Text zerlegst, entscheidet über die Qualität deiner Matches. Über eine detailliert Chunking-Strategie gab Daniel leider keine Auskunft.

Um diese Vektoren dann auch performant durchsuchbar zu machen, kam der Faiss-Index zur Sprache. Wer schon mal Millionen von Datenpunkten vergleichen musste, weiß: Ohne effiziente Vektorsuche wartest du bis zum nächsten Google Core Update auf dein Ergebnis.

Das Herzstück für diese Berechnungen? Google Colab. Hier bin ich voll bei Daniel: Wer sich noch nicht in Colab eingegroovt hat, sollte das dringend nachholen. Ja, es ist technisch. Ja, du musst vielleicht ein paar Zeilen Python verstehen. Aber es gibt dir die Power, Datenanalysen zu fahren, von denen Excel-User nur träumen.

Kennen bzw. Können wir das bei KLIXPERT?

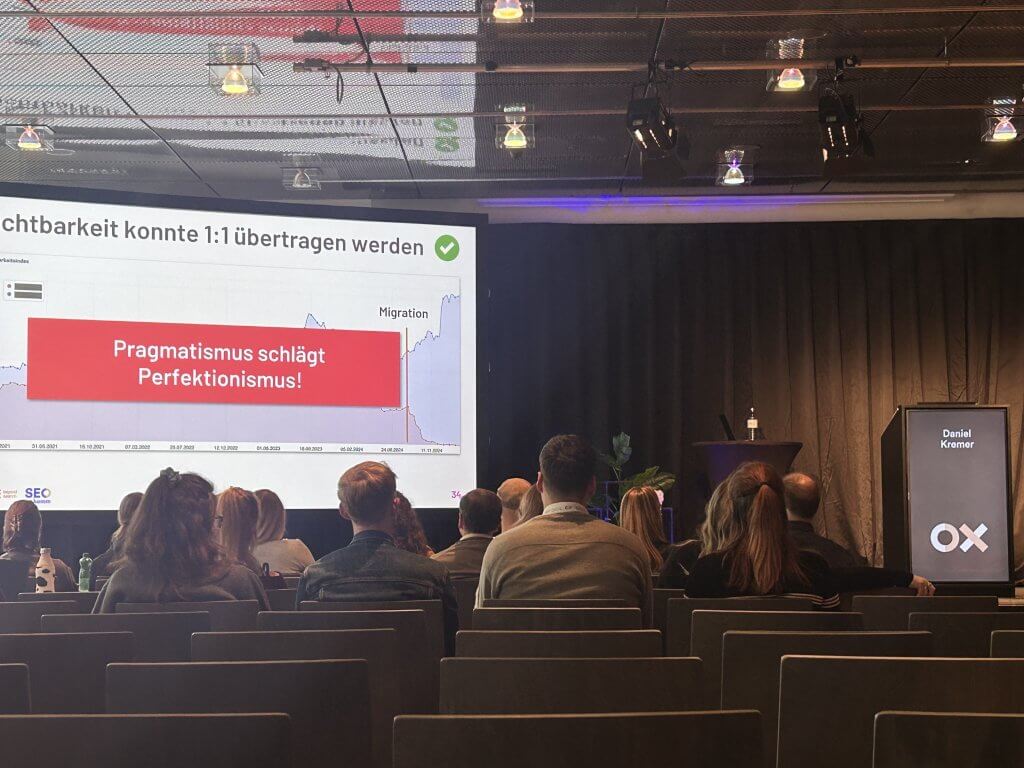

Jep … das haben wir in diesem Jahr bei der Migration eines Shops von WordPress auf Shopify ganz ähnlich gehandhabt. Der Case war zwar nicht derart groß wie hier im Track präsentiert, aber das Ergebnis zeigt uns, dass wir nahezu alles richtig gemacht haben. Ein ähnlicher Ansatz, das eine oder andere Tool etwas anders genutzt, aber das Ergebnis ist dasselbe. Na ja … da merkt man, dass die Tiroler und bayerische Denkweise nicht allzu weit auseinanderliegen.

Strategie: Der Q-Wert und der Mut zur Lücke

Ein Konzept, das ich zu 100 % unterschreibe: Ein schwacher Q-Wert (Quality Value) einzelner Seiten zieht deine gesamte Domain runter. Google bewertet die Gesamtqualität. Wenn du beim Relaunch Müll mitschleppst, “weil wir das schon immer so hatten”, schadest du der Performance der gesamten Seite.

Daniel’s Ansatz:

- Immer weiterleiten: Bevor du Traffic auf einer 404 sterben lässt, leite ihn weiter. Traffic ist Währung.

- Soft 404s: Fixe sie im Nachgang, wenn nötig. Blockier dich nicht damit vor dem Go-Live.

Und hier kommt mein Lieblings-Takeaway der Session: 80% richtig zu machen, reicht oft aus. Niemand schafft die 100%. Der Versuch, die perfekte Migration hinzulegen, führt oft nur zu Analysis Paralysis. Ship it, miss die Daten, iteriere. Das ist genau das Mindset, das wir im Growth Marketing und in der Softwareentwicklung brauchen. Perfection is the enemy of done.

Fazit

Relaunches müssen nicht wehtun, wenn man die richtigen Tools und das richtige Mindset mitbringt. Die Kombination aus soliden Daten (Screaming Frog), moderner AI-Technologie (Embeddings/Faiss) und einer pragmatischen Strategie (80/20) ist der Weg nach vorne. Wer heute noch Relaunches ohne Python und Vektoren plant, fährt mit der Kutsche auf der Autobahn.

Tech Stack & Tools dieser Session

Damit du direkt in die Umsetzung kommst, hier die Tools, die in Daniels Session und meinem Recap eine Rolle spielten:

- Screaming Frog SEO Spider: Der unangefochtene Industriestandard für Website-Crawling. Für einen Relaunch ist er unverzichtbar, weil er weit mehr kann als nur Statuscodes zu checken. Mit Custom Extraction (via XPath oder Regex) ziehen wir uns gezielt die Content-Fragmente aus dem DOM, die wir für die Embeddings brauchen. Er rendert JavaScript, visualisiert die Site-Struktur und verknüpft Crawl-Daten direkt mit APIs wie Google Analytics oder der Search Console. Ohne den Frosch fehlt dir die Datenbasis für jede ernsthafte Analyse.

- Sentence Transformers (Hugging Face)*: Python-Frameworks, um Sätze und Absätze in dichte Vektorräume (Embeddings) zu übersetzen. Kurz erklärt: Embeddings verwandeln Text in Zahlenkoordinaten. Dadurch verstehen Maschinen den Kontext – Wörter mit ähnlicher Bedeutung (z.B. “Relaunch” und “Migration”) landen im mathematischen Raum nah beieinander. Damit lassen sich Texte semantisch vergleichen (z.B. “Ist der neue Text inhaltlich noch relevant zum alten?”).

- Faiss (Facebook AI Similarity Search): Eine Bibliothek für effiziente Ähnlichkeitssuche in Vektoren. Essenziell, wenn du große Mengen an URLs und Inhalten schnell gegeneinander matchen willst.

- Google Colab: Eine gehostete Jupyter-Notebook-Umgebung. Sie läuft im Browser, bietet kostenlosen Zugang zu GPUs (wichtig für die Berechnung der Embeddings!) und ist der perfekte Spielplatz für Python-basierte SEO-Analysen.

Über den Speaker: Daniel Kremer

Daniel ist Gründer & SEO-Experte bei ONE Beyond Search. Seit 2016 baut er skalierbare SEO-Strategien, bei denen Technik und Strategie Hand in Hand gehen. Was mir an Daniel gefällt: Er redet nicht nur über AI, er nutzt sie, um Workflows fundamental zu verändern. Sein Fokus liegt darauf, durch Daten und KI Raum für echtes strategisches Denken zu schaffen.

*Es wurden die Embeddings von OpenAI und anderen im Track erwähnt, ich persönlich bin aber ein Fan von Sentence Transformers fürs Embedding.

Meine Posts zur SEOkomm 2025

- Agentic Workflows statt One-Prompt-Wonder – KI-Automatisierung im SEO

- The Next Frontier of Discovery – Von Suchergebnissen zu echter “Action”

- Browser-Based SEO – Warum die Chrome DevTools dein stärkster Hebel sind

- Relaunch done right – Vektor-Embeddings, Screaming Frog & warum Perfektionismus dein Ranking killt

- Vom SEO-Dashboard zum GEO-Framework – Belastbare KPIs für die neue Ära der Suche

- Die harte Wahrheit über Traffic & die 10%, die bei SEO & AEO den Unterschied machen

Was ist die SEOkomm 2025 und OMX (Online Experts Days) 2025

Die SEOkomm und die OMX (Online Experts Days) sind die beiden zentralen Fachkonferenzen der sogenannten “Online Expert Days” (OXD), die jährlich in Salzburg stattfinden und als führende Weiterbildungsveranstaltung für die digitale Marketingbranche im deutschsprachigen Raum gelten. Die OMX, welche am ersten Tag (27. November 2025) stattfindet, konzentriert sich auf das breite Feld des Online Marketings – inklusive E-Commerce, Social Media, SEA (Search Engine Advertising), B2B Marketing und mehr. Die SEOkomm am darauffolgenden Tag (28. November 2025) legt den Fokus dezidiert auf die Suchmaschinenoptimierung (SEO) und behandelt Themen wie Technical SEO, Content-Strategien, KI im Digital Marketing sowie aktuelle Trends und Tools.